本地AI视频创作爆发力,FramePack让6G显存也能动起来!

还记得首次用 Stable Diffusion 生成图像的惊艳感觉吗?后来你可能也尝试过能“控制”图片内容的 ControlNet ——那是AI图像生成领域的一次飞跃。现在,这位技术大神张吕敏又带来了他的全新开源项目:FramePack。

s一台普通笔记本,一张6GB显存的显卡,一张静态图片,配上一段简单的英文描述,你就能看到画面“活”起来。女孩旋转起舞、古画缓缓流动、赛博世界跃然眼前,这一切,不再是遥不可及的想象。

猜猜要生成上面的视频需要使用多少算力?

过去,答案往往是需要多张A100一起工作。

而现在,使用新发布的 FramePack,只需要一个带有 6GB GPU 内存的 RTX 3060 笔记本,就可以在本地流畅地生成。

FramePack一经发布,在外网上也是收获了一波好评。

接下来,让我们一起了解一下 FramePack 究竟是如何做到的。

项目地址:

https://lllyasviel.github.io/frame_pack_gitpage/

代码地址:

https://github.com/lllyasviel/FramePack

FramePack的原理及核心优势

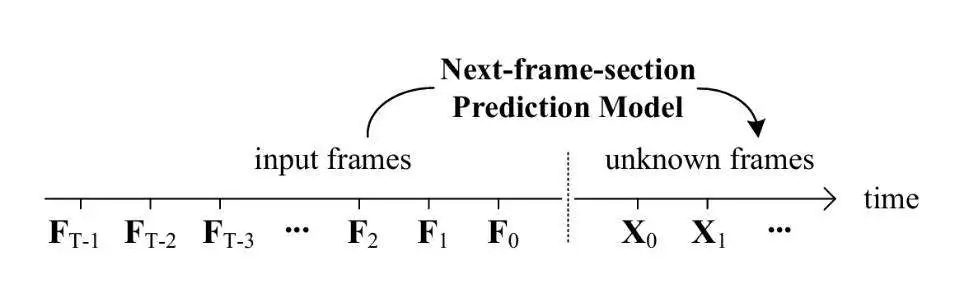

FramePack 是由斯坦福大学的 Lvmin Zhang 和 Maneesh Agrawala 联合发布的一种 next-frame(next-frame-section)预测神经网络结构,可以逐步生成视频。

顺便提一嘴,Lvmin Zhang 就是大名鼎鼎的ControlNet 的作者张吕敏。

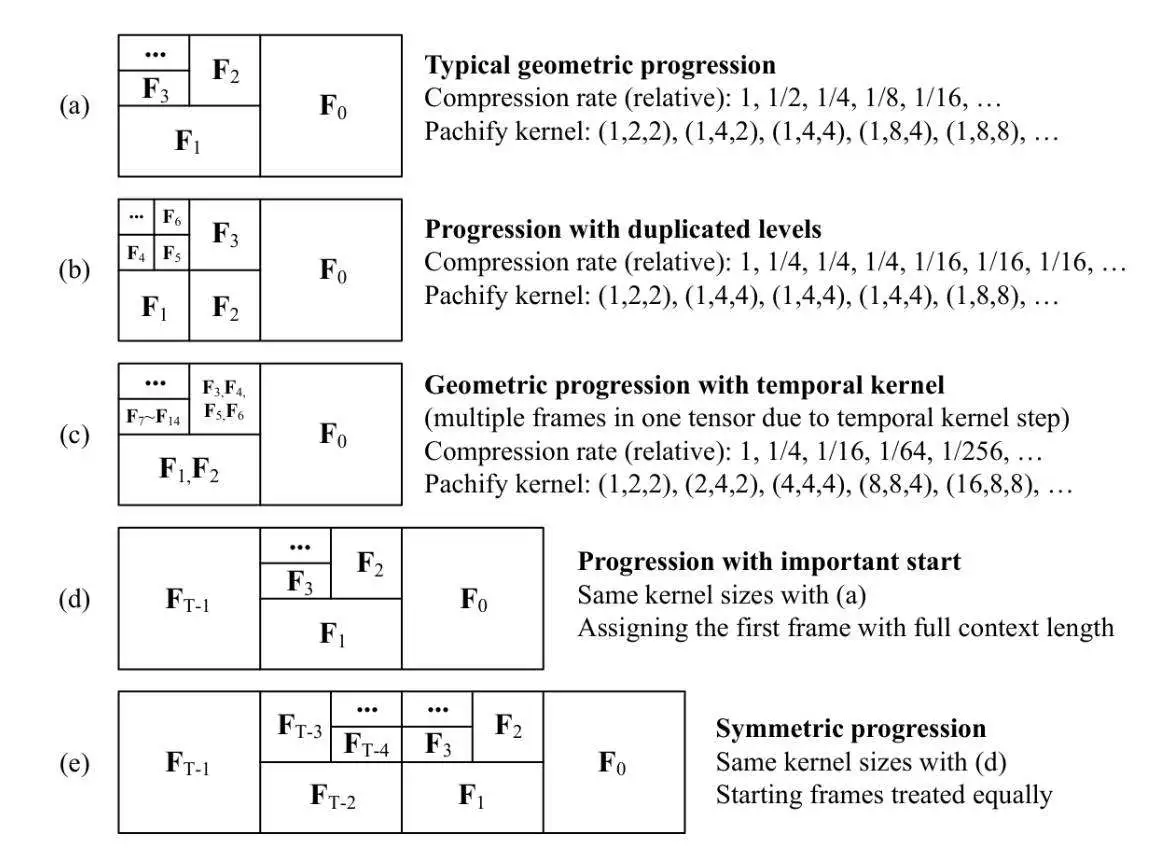

FramePack 将输入上下文压缩为恒定长度,并且根据帧的重要性实现不同的压缩模式。

这样的操作显著降低了对 GPU 显存的要求,从而实现了与图片扩散模型相似的计算消耗。

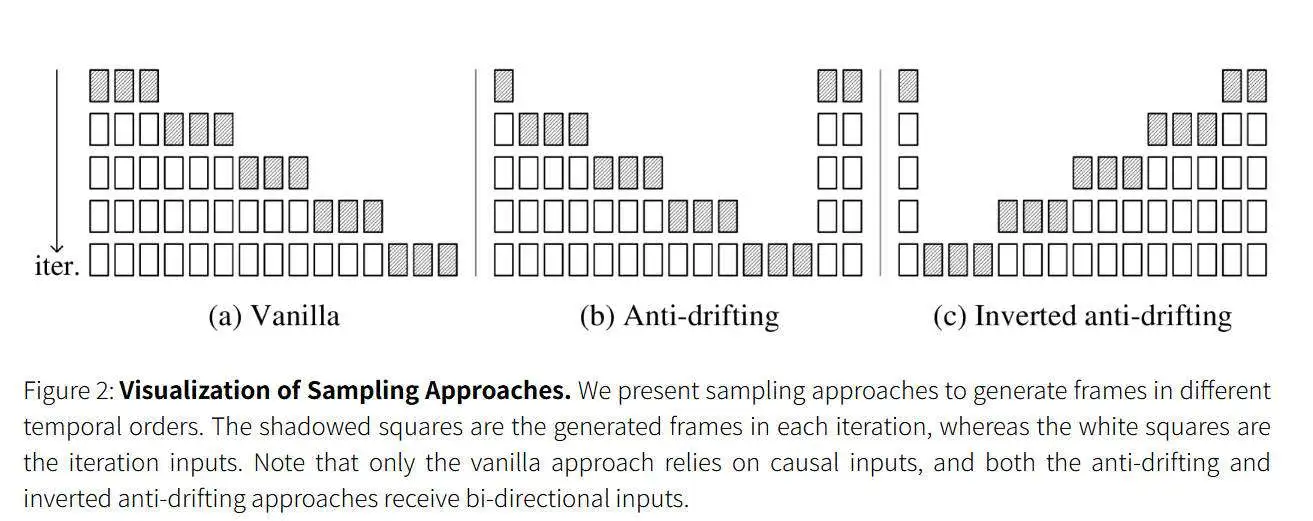

为了缓解“漂移”现象,FramePack 提出了三种反漂移采样方法。

btw 漂移是指在下一帧预测模型中出现的视觉质量会随着视频长度的增加而下降的问题。

实验发现第三种采样方法可以将用户的输入视为高质量的第一帧,并不断优化生成以接近用户帧,从而可以获得整体高质量的视频。

这就意味着在不显著牺牲品质的情况下,FramePack 可以生成更长时间的视频。

并且用户能够即时查看每一帧生成后的画面,方便进行预览和调整。

KEJI YIANG 软件介绍

FramePack「WIN 平台」

🖼️操作界面介绍

FramePack 提供了极简但实用的图形界面(GUI):

左侧上传图片和输入提示词(prompt)

右侧实时预览视频生成过程,可查看每一帧的效果和进度条

它不像传统渲染那样“生成即等待”,而是每段帧实时呈现——生成中途就能判断效果,节省大量试错时间。

💡技术细节爱好者看这里

支持多种注意力机制(PyTorch attention / xformers / flash-attn 等)

可使用 teacache 提升速度,RTX 4090上最快达到1.5 秒/帧

支持 fp16、bf16 等精度计算优化

支持大批次模型训练,适合科研或高端个人使用

⚠️整合包注意事项

虽然支持低配置运行,但建议内存 ≥16GB,确保顺畅体验

Teacache 与量化会略影响画质,可先用于预览试验

GTX 显卡暂未测试,推荐 RTX 系列以上设备

🎯总结:AI 视频生成的真正普及时刻到了

FramePack 是目前为止最具可玩性、普及性和效率的视频扩散生成工具之一。它不仅让AI视频“飞入寻常家”,更标志着下一代生成模型对“硬件依赖”的彻底突破。

如果你想让静态画面动起来、创作独特视频作品、试水AI内容生成,不妨亲自试试 FramePack ——也许,这会是你走进AI视频世界的第一扇门。